Инженеры ускорили обучение нейросетей на CPU более чем в два раза

Израильский ИИ-стартап Deci объявил о достижении «прорывной производительности глубокого обучения» с использованием центральных процессоров (CPU).

The news is out! 🎉 We’re excited to announce that our family of image classification models called DeciNets reached a new level of industry-leading performance on large CPUs including Intel’s Cascade Lake. /1 pic.twitter.com/aCKGBDFpGo

— Deci AI (@deci_ai) February 16, 2022

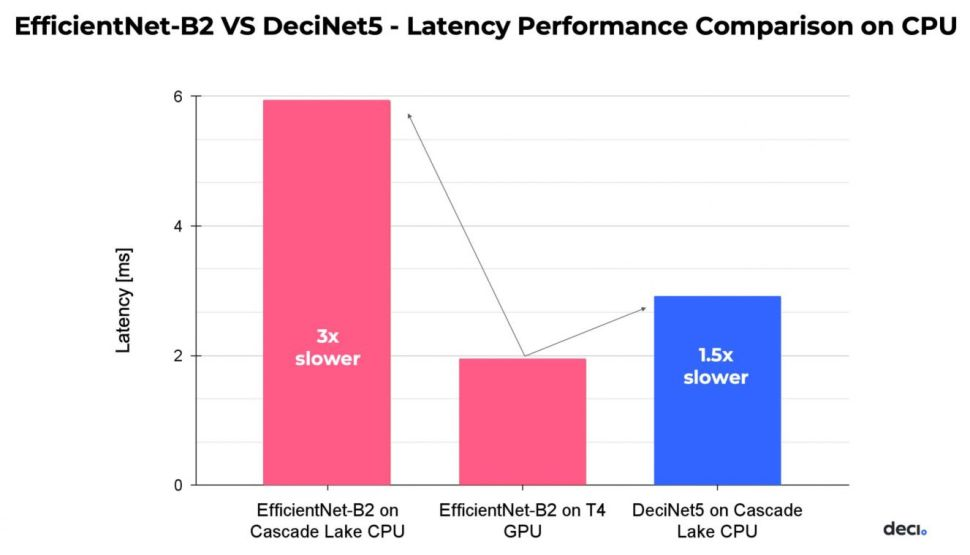

По словам представителей компании, модель классификации изображений DeciNets оптимизирована для использования на процессорах Intel Cascade Lake. Она использует запатентованную Deci технологию Automated Neural Architecture Construction (AutoNAC) и работает на CPU более чем в два раза быстрее и точнее, чем EfficientNets от Google на аналогичном оборудовании.

Сравнение скорости обучения моделей на разном оборудовании. Данные: Deci.

Соучредитель и генеральный директор Deci Йонатан Гейфман заявил, что их цель разрабатывать не только более точные модели, но и ресурсоэффективные.

«AutoNAC создает лучшие на сегодняшний день модели компьютерного зрения, и теперь новый класс сетей DeciNet можно применять и эффективно запускать приложения ИИ на процессорах», — добавил он.

В компании также сообщили, что уже почти год работают с Intel над оптимизацией глубокого обучения на процессорах корпорации. Несколько клиентов Deci уже внедрили его технологию AutoNAC в производственных отраслях, добавили они.

Классификация изображений и распознавание объектов входят в число основных задач, для которых применяются алгоритмы глубокого обучения. По словам экспертов, сокращение разрыва производительности между GPU и CPU поможет не только удешевить разработку современных ИИ-алгоритмов, но и снизить нагрузку на рынок видеоускорителей.

Напомним, в апреле 2021 года ученые из Университета Райса разработали новый механизм глубокого обучения, который тренирует нейронные сети на центральном процессоре в 4—15 раз быстрее, чем на GPU.

В мае ученые с помощью ИИ ускорили моделирование Вселенной в 1000 раз.

Источник: Источник