Cerebras побил рекорд в обучении ИИ-модели на одном устройстве

Американский стартап Cerebras обучил «самую большую модель искусственного интеллекта» на одном устройстве, оснащенном чипом Wafer Scale Engine 2 (WSE-2) размером с тарелку. Об этом пишет Tom’s Hardware.

«Используя программную платформу Cerebras (CSoft), наши клиенты могут легко обучать современные языковые модели GPT (такие как GPT-3 и GPT-J) с использованием до 20 млрд параметров в одной системе CS-2», — говорится в заявлении компании.

По словам представителей стартапа, технология Cerebras Weight Streaming отделяет вычислительные ресурсы, позволяя масштабировать память до любого объема, необходимого для хранения быстро растущего числа параметров в рабочих нагрузках ИИ.

«Работающие на одном CS-2 модели настраиваются за несколько минут, и пользователи могут быстро переключаться между ними всего несколькими нажатиями клавиш», — говорится в заявлении.

Хранение до 20 моделей обработки естественного языка с миллиардами параметров в одном чипе значительно снижает накладные расходы на обучение и масштабирование с помощью тысяч графических процессоров, считают в компании. Они добавили, что это один из самых болезненных аспектов рабочих нагрузок NLP, на выполнение которого уходят месяцы.

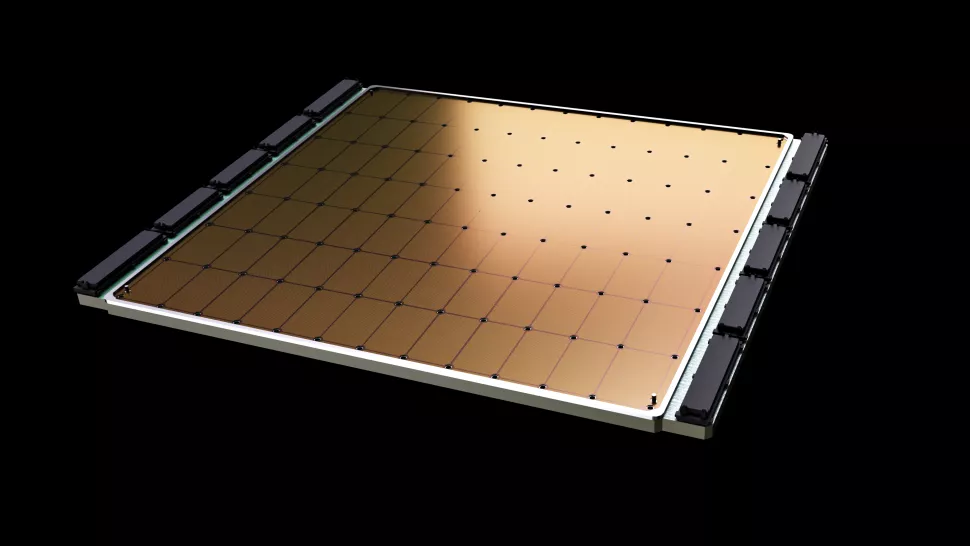

Чип Wafer Scale Engine 2 построен по 7-нм техпроцессу, содержит 850 000 ядер, имеет 40 ГБ встроенной памяти с пропускной способностью 20 ПБ/с и потребляет около 15 кВт.

Чип Wafer Scale Engine 2. Данные: Cerebras

Напомним, в апреле 2021 года Cerebras представила процессор WSE-2, предназначенный для расчетов в области машинного обучения и искусственного интеллекта..

В августе компания создала суперкомпьютер CS-2. Установка на базе чипов WSE-2 способна обучить ИИ-модель со 120 млрд параметров.

В мае 2022 года рейтинг самых мощных суперкомпьютеров мира Top500 возглавила американская система Frontier, разработанная Ок-Риджской национальной лабораторией. Это первая установка, достигшая пикового значения 1,1 экзафлопса в тесте Linmark.

Источник: Источник